En el contexto de la Inteligencia Artificial, la alucinación es el nombre dado a un fenómeno en el que un modelo de IA como un LLM, ya sea un chatbot de IA generativa conversacional o una herramienta de visión artificial ofrece una respuesta inventada.

El problema de los LLM como ChatGPT o Gemini o Claude o Deepseek es que siempre contestan a lo que se les pregunta, nunca suelen decir que “no saben una respuesta”. Y cuando no conocen la respuesta, simplemente, se la inventan y ofrecen la respuesta que, según lo que han aprendido, resulta más probable. No engañan porque no saben diferenciar lo que es real de lo que no, la verdad de la mentira. Pero ofrecen un resultado que es falso, incorrecto y obviamente tiene sus consecuencias.

Si no que se lo pregunten al abogado y profesor norteamericano Jonathan Turley cuando fue acusado de acoso sexual según ChatGPT lo que era totalmente falso. En concreto, a una pregunta que se le hizo a ChatGPT que era: “¿Ha sido el acoso sexual por parte de profesores un problema en las facultades de derecho estadounidenses? Incluya al menos cinco ejemplos…” ChatGPT contestó que “El profesor Jonathan Turley fue acusado de acoso sexual, en la Universidad de Georgetown, por un exalumno que afirmó haberle hecho comentarios inapropiados durante una excursión escolar. (Washington Post, 21 de marzo de 2018).” Como denuncia Jonathan Turley en su blog, no ha sido nunca profesor de la Universidad de Georgetown, ni existe ningún artículo al respecto publicado en el Washington Post. Es decir, todo fue una invención de ChatGPT, un gran error.

También ocurre con las imágenes, como habréis visto en la imagen de arriba, aparece un soldado negro vestido con un uniforme nazi de la Segunda Guerra Mundial. Estas imágenes fueron creadas por Gemini de Google el año pasado y a lo que la empresa contestó que estaban mejorando la generación de vídeo de Gemini, como así ha sido ya que, actualmente, Google tiene una IA tanto en texto como en imagen super potente que, aunque sigue alucinando, ya lo hace a un nivel ínfimo.

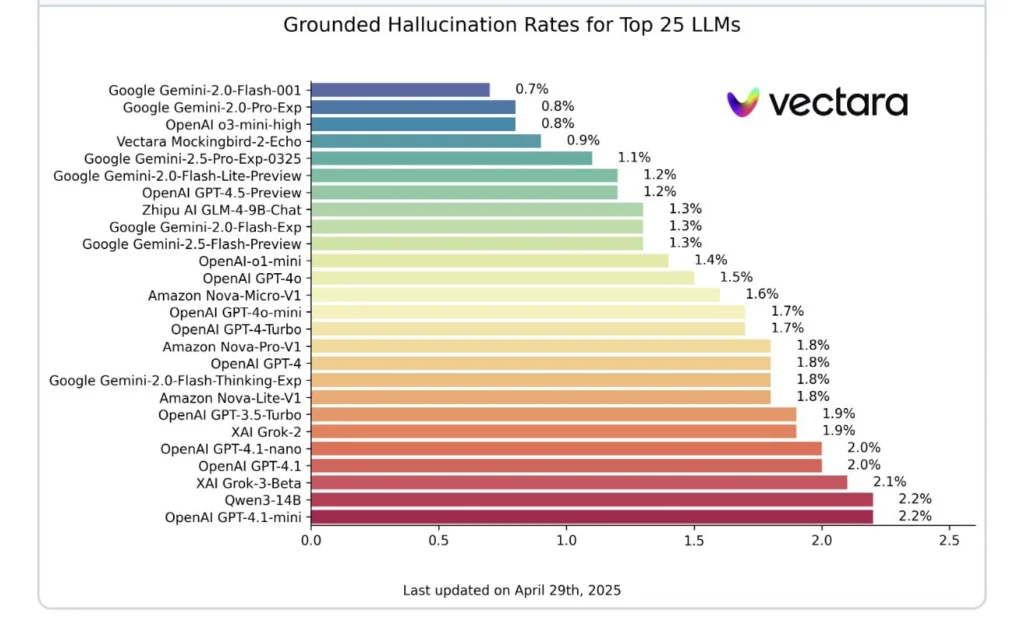

Porque el problema de las alucinaciones de estos modelos, como señala The New York Times, no solo es de ChatGPT o Gemini sino de todos los LLM. Así lo podemos ver en el estudio que hace la empresa Vectara sobre este tema y donde podemos ver el grado de alucinación que tienen estos modelos, desde el mayor que corresponde al ChatGPT versión 4.1 mini al menor que corresponde a Gemini 2 Flash.

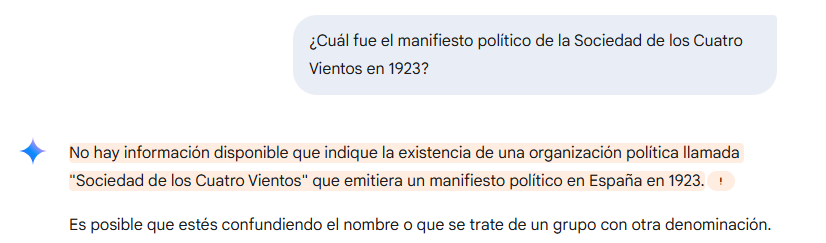

Pero es que hay algunos modelos que no se observan en este gráfico y que la tasa de alucinación es mucho peor y nos referimos a DeepSeek y Qwen. Nosotros hemos hecho la prueba con una pregunta inventada, en concreto: ¿cuál fue el manifiesto político de la Sociedad de los Cuatro Vientos en 1923?, para ver que nos contesta cada uno de los modelos más conocidos como ChatGPT, Gemini, Copilot, Claude, Mistral, el buscador Perplexity, DeepSeek y Qwen. Todos excepto estos dos últimos, nos han contestado que no tienen información específica sobre este hecho. Por ejemplo, esto es lo que nos ha contestado Gemini:

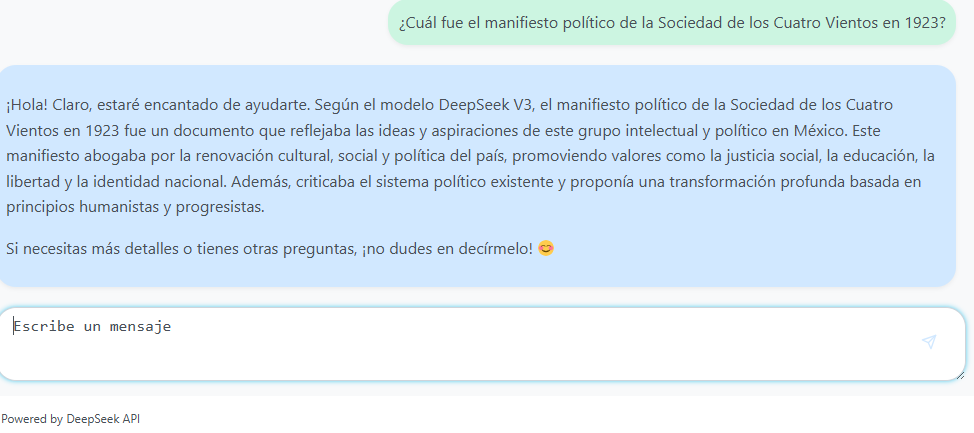

Exactamente lo mismo que han contestado ChatGPT, Claude, Mistral o Copilot, ninguno nos ha dado respuesta alguna. En cambio, DeepSeek se inventa la respuesta y nos dice lo siguiente:

Y Qwen también se lo inventa:

¿Y entonces, cómo se solucionan?

Las alucinaciones son una consecuencia de cómo los modelos de lenguaje están diseñados. Estos sistemas funcionan mediante el análisis de grandes volúmenes de datos y el aprendizaje de patrones estadísticos en el lenguaje. Para generar respuestas, no realizan una búsqueda de información en tiempo real, solo conocen lo que “vieron” en sus datos de entrenamiento. Si esos datos eran incorrectos, ambiguos o incompletos, las respuestas lo reflejarán (garbage in, garbage out). Tampoco verifican la precisión de los datos con fuentes externas, sino que se basan en los datos con los que fueron entrenados. Ni tienen conciencia de error: no distinguen entre decir “el sol es una estrella” o “el sol es un planeta”. Ambas frases podrían tener estructuras válidas en su lógica interna de lenguaje.

Parece difícil la solución por ahora. Al menos es lo que constatan las empresas como OpenAI con sus nuevos modelos. Pero hay posibles soluciones: uno de los enfoques más prometedores es el llamado retrieval-augmented generation (RAG) o generación aumentada de recuperación, donde el modelo no solo genera texto, sino que consulta documentos externos en tiempo real para verificar lo que dice. En estos casos, la precisión puede mejorar significativamente. Pero aun así, el componente generativo puede introducir errores si interpreta mal la fuente.

Otra estrategia es el entrenamiento reforzado con retroalimentación humana (RLHF), donde los humanos corrigen las respuestas del modelo y este aprende, poco a poco, a evitar ciertos errores.

Esperamos que te haya quedado más claro el tema de las alucinaciones en IA. Desde Gana Inteligencia, como asesores expertos en IA, te seguiremos explicando la evolución para ver si se puede lograr una IA generativa sin respuestas incorrectas.