Durante años, para millones de gamers, la palabra Nvidia evocaba una única emoción: deseo. Era la marca impresa en las tarjetas gráficas que prometían hacer correr el último Call of Duty como mantequilla caliente sobre una sartén. Pero lo que comenzó como una empresa de hardware para entusiastas de los videojuegos ha acabado convertida en el corazón palpitante de la inteligencia artificial moderna. Pero, ¿cómo ha pasado Nvidia de alimentar batallas virtuales en FortNite a sostener la infraestructura de la IA?

De píxeles a parámetros: la metamorfosis de una GPU

La clave está en un acrónimo: GPU, o Graphics Processing Unit. Estos chips, diseñados originalmente para renderizar imágenes a alta velocidad, poseen una arquitectura única: son capaces de ejecutar miles de tareas en paralelo. A diferencia de los procesadores tradicionales (CPU), que son como oficinistas metódicos —uno tras otro, ordenadamente—, las GPUs son como enjambres de abejas, cada una atacando una flor distinta al mismo tiempo.

Y resulta que este enfoque es justo lo que necesitan los modelos de inteligencia artificial, especialmente los de aprendizaje profundo (deep learning), para entrenarse. En vez de renderizar sombras en un videojuego, hoy esas GPUs procesan millones (o billones) de datos, ajustando redes neuronales con la paciencia obstinada de un relojero suizo… pero a la velocidad de la luz.

De pronto, lo que antes era un chip para videojuegos se convirtió en el nuevo oro digital. Las mismas tarjetas gráficas que antes se disputaban los gamers, ahora son codiciadas por científicos, empresas tecnológicas y gobiernos.

Nvidia: la empresa que leyó el futuro antes que nadie

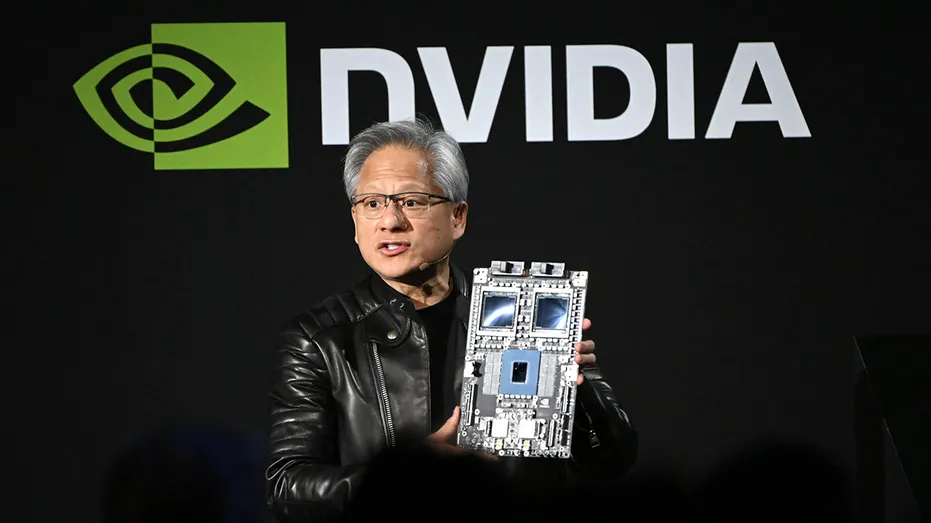

Nvidia nació en 1993, fundada por Jensen Huang (quien, con su chaqueta de cuero y tono de rockstar, es hoy una de las figuras más influyentes del mundo tecnológico), Chris Malachowsky y Curtis Priem. Su apuesta inicial fue clara: crear procesadores gráficos especializados en una época donde eso aún no era prioridad. Mientras Intel se concentraba en CPUs, Nvidia apostó por algo más lateral, más arriesgado… y, con el tiempo, más lucrativo.

Pero la genialidad no fue solo técnica, sino estratégica. A medida que investigadores comenzaban a utilizar GPUs para entrenar algoritmos de IA, Nvidia no solo les siguió el paso: se les adelantó. Invirtió en software (como CUDA, su plataforma de programación paralela), diseñó chips cada vez más potentes y desarrolló hardware específico para inteligencia artificial, como la serie H100 o el más reciente B200, auténticas bestias del cálculo que pueden costar decenas de miles de dólares cada uno… y aún así se agotan.

¿El resultado? Nvidia controla hoy más del 80% del mercado de chips para IA. Es, en términos prácticos, el proveedor de oxígeno de la inteligencia artificial contemporánea.

Los primeros años fueron duros. La empresa lanzó su primer chip, el NV1, en 1995, pero fue un fracaso comercial. Sin embargo, los fundadores persistieron. En 1999 lanzaron la GeForce 256, que fue revolucionario porque fue el primer chip en ser llamado oficialmente «GPU». Este procesador no solo manejaba gráficos, sino que también incluía funciones de transformación e iluminación, liberando al CPU principal de estas tareas.

Durante los años 2000, NVIDIA se estableció como líder en el mercado de tarjetas gráficas para gaming, compitiendo ferozmente con ATI (ahora parte de AMD). Cada nueva generación de GPU era más poderosa, más eficiente, y capaz de crear efectos visuales más impresionantes.

Pero Jensen Huang tenía una visión más amplia. En 2006, NVIDIA lanzó CUDA (Compute Unified Device Architecture), una plataforma que permitía a los programadores usar las GPU para cálculos generales, no solo gráficos. En ese momento, muchos no entendieron completamente las implicaciones de esta decisión. Era como si hubieran creado un idioma universal que permitiría que las GPU hablaran con todo tipo de aplicaciones científicas y de investigación.

La Tormenta Perfecta: Cuando la IA Encontró su Hardware Ideal

El momento decisivo llegó alrededor de 2012. Los investigadores de inteligencia artificial estaban experimentando con redes neuronales profundas, pero se enfrentaban a un problema masivo: el poder computacional necesario era astronómico. Entrenar estos modelos con CPU tradicionales era como tratar de llenar una piscina con una pajita.

Fue entonces cuando investigadores como Geoffrey Hinton en la Universidad de Toronto comenzaron a experimentar con GPU de NVIDIA para entrenar sus redes neuronales. Los resultados fueron espectaculares. Lo que tomaba semanas ahora tomaba días. Los modelos podían ser más grandes, más complejos, y más precisos.

Alex Krizhevsky, un estudiante de Hinton, usó dos GPU NVIDIA GTX 580 para crear AlexNet, una red neuronal que ganó la competencia ImageNet de 2012 por un margen tan amplio que dejó a todos boquiabiertos. Este fue el momento que muchos consideran el inicio del boom moderno de la IA.

NVIDIA se dio cuenta rápidamente de lo que estaba sucediendo. Jensen Huang, con su característica visión a largo plazo, comenzó a invertir masivamente en optimizar sus chips específicamente para aplicaciones de IA. No era suficiente tener GPU potentes; necesitaban GPU diseñadas para manejar los tipos específicos de cálculos que requiere el machine learning.

La Arquitectura del Pensamiento Artificial

Para entender por qué NVIDIA se volvió tan crucial para la IA, necesitamos profundizar en cómo funcionan realmente los sistemas de inteligencia artificial modernos. Cuando interactúas con ChatGPT o cualquier otro chatbot avanzado, lo que está sucediendo detrás de escena es extraordinariamente complejo.

Primero, tu texto se convierte en números a través de un proceso llamado tokenización. Cada palabra, cada signo de puntuación, se traduce a valores numéricos que la computadora puede procesar. Luego, estos números pasan a través de lo que llamamos una red neuronal, que es esencialmente una simulación matemática muy sofisticada de cómo creemos que funciona nuestro cerebro.

Esta red neuronal está compuesta por millones o incluso billones de parámetros: números que determinan cómo el modelo procesará la información. Cuando el modelo está «pensando» en tu pregunta, está realizando operaciones matemáticas con todos estos parámetros simultáneamente. Es como si tuviera que consultar millones de pequeñas notas mentales al mismo tiempo para formular una respuesta.

Aquí es donde brillan las GPU de NVIDIA. Cada uno de estos cálculos es relativamente simple: principalmente multiplicaciones y sumas de matrices. Pero hay que hacer billones de ellos, y todos al mismo tiempo. Las GPU modernas de NVIDIA, como las de la serie H100, tienen miles de núcleos de procesamiento trabajando en paralelo, cada uno manejando una pequeña parte del cálculo total.

Pero NVIDIA no se detuvo ahí. Se dieron cuenta de que podían optimizar aún más sus chips para IA. Introdujeron unidades especializadas llamadas Tensor Cores, que están diseñadas específicamente para los tipos de operaciones matemáticas que más usa la inteligencia artificial. Es como tener herramientas especializadas en lugar de usar un martillo para todo.

El monopolio silencioso

He aquí una de las ironías más jugosas de esta historia: la inteligencia artificial, símbolo por excelencia del progreso y la diversidad algorítmica, está construida sobre una infraestructura sorprendentemente homogénea. Es como descubrir que todos los poemas de amor del mundo se escriben con la misma pluma.

La antítesis es clara: hablamos de máquinas capaces de simular creatividad infinita, pero dependientes de un puñado de empresas para existir. Nvidia no compite con decenas de fabricantes. Está sola en la cima de una montaña que ella misma cavó con paciencia tectónica. Y aunque los gobiernos y otras empresas tecnológicas intentan desarrollar alternativas (como los chips TPUs de Google o los proyectos de Intel), por ahora, el futuro pasa por los laboratorios de Nvidia.

Desde Gana Inteligencia, como asesores expertos en el sector de la IA, te informamos de temas claves en el sector como la importancia de las GPUs de Nvidia. Si tienes alguna duda o necesitas información sobre algún tema relacionado con la IA no dudes en consultarnos. Somos asesores expertos en IA.